Che fine ha fatto il web dei primi anni Novanta? Quello che esisteva prima delle grandi piattaforme, le quali monopolizzano gli utenti le cui comunicazioni (i “contenuti”) a loro volta oggi possono così essere facilmente monitorate e controllate. Certo, ci sono ancora cose old style, soprattutto sui livelli alternativi realmente decentralizzati (per esempio ZeroNet), ma la rete di pagine web composte da geek e smanettoni è letteralmente scomparsa: nascosta da Google, “irrilevante” per Facebook, spesso uccisa dalla chiusura dei grandi contenitori della prima ora (Geocities e altri).

C’è un altro problema, però. L’Atlantic lo riassume con un titolone a effetto: The Internet Is Rotting. E l’idea è semplice: la colla che tiene assieme la conoscenza umana si sta sciogliendo, internet sta marcendo e perdiamo costantemente moltissima conoscenza.

La colla sono i link, non sono le pagine. Dopotutto il web è un ipertesto ed è costruito sull’idea di collegare la conoscenza: non soltanto la ricerca (Google) o il flusso (Facebook e Twitter) ma la possibilità di passare da una pagina all’altra grazie ai link. Per esempio, come il link all’articolo dell’Atlantic, che da questo testo che stai leggendo si raggiunge con un deep link (un link a una specifica pagina, anziché alla home di un sito). Perché questo succeda, però, bisogna che quel link funzioni, cioè che la pagina sia disponibile nella forma vista da me a quell’indirizzo. E invece questo molto spesso non succede più.

La ricerca fatta da Zittrain, autore dell’articolo in questione nonché professore di informatica e diritto, mostra che un quantitativo enorme di link usati dal 1996 in avanti non funzionano più, sono “rotti”. Caso eclatante, il giornale più famoso del mondo: il 25% di quelli contenuti negli articoli del New York Times (il giornale è online dal 1996) non funziona, e se si guardano gli articoli più vecchi (pubblicati prima del 2000) la quantità diventa un mostruoso, sconfortante 72%.

I link falliscono non solo perché il contenuto viene tolto dalla Rete. Invece, molto più spesso quel che succede è che cambia l’indirizzo perché il sito viene ristrutturato. Nel 2016 dei ricercatori dell’università di Princeton hanno visto che il 75% dei paper a cui faceva riferimento il corpus di 3,5 milioni di articoli raccolto, avevano cambiato indirizzo. Come se i libri di casa tua finissero a casa di qualcun altro, oppure se la copertina rimanesse ma cambiasse (o non si trovasse più) il contenuto.

Nel 2007, un’inchiesta giornalistica in 34 episodi pubblicata sul sito del Rocky Mountain News valse al suo autore Kevin Vaughan la finale del Premio Pulitzer. Nel 2009, in seguito alla crisi dello storico quotidiano del Colorado, l’intero reportage — testi, foto, video, grafiche — scomparve dal web. Nessuna biblioteca ne conservava una copia, nessun archivio ne custodiva i file, nessuna persona ne possedeva un esemplare: l’inchiesta, chiamata “The Crossing”, era svanita nel nulla.

È servito un lavoro di anni per recuperare i file, le immagini e tutto il materiale necessario a riportare in vita la serie, oggi pubblicata sull’apposito sito The Crossing Story. Ma quello fu un trattamento privilegiato, riservato a un’opera in competizione per il Pulitzer.

Nello stesso lasso di tempo, centinaia di milioni di siti, blog e piattaforme sono invece andati perduti definitivamente, compresi link utilizzati da giudici della Corte Suprema statunitense nelle loro motivazioni o l’intero spaccato socioculturale contenuto nei sedici anni di (stravaganti) domande e risposte conservate su Yahoo Answer.

Chi pensa che le pagine andate perdute siano una trascurabile minoranza, si sbaglia di grosso: uno studio condotto nel 2014 mostrava come già allora il 75% dei link contenuti sul sito della prestigiosissima Harvard Law Review non fosse più funzionante.

È la stessa caratteristica fondante del world wide web a causare tutto ciò: non c’è una realtà proprietaria della Rete che si faccia carico di custodire tutto. La responsabilità è diffusa tra ogni attore che partecipa al web: dai colossi digitali al singolo blogger che deve pagare il server che ospita il suo sito. Ciò crea inevitabilmente problemi di manutenzione che non sono solo tecnologici, ma riguardano prima di tutto la conservazione del nostro patrimonio culturale.

È un titanico problema di permanenza della conoscenza, e al tempo stesso una sconfitta enorme per tutti noi.

I detective del “marcio”

La situazione è talmente seria da aver dato vita a una piccola economia sotterranea, in cui alcuni faccendieri del web pagano dei tecnici specializzati affinché scovino i link rotti contenuti su siti estremamente diffusi, come la BBC o Il Corriere della Sera, e che di conseguenza ricevono ancora numerose visite.

Ma vanno oltre. Una volta trovato un intero sito non più in funzione ma diffusamente linkato in giro, ne acquistano il dominio e lo utilizzano per ospitare delle pubblicità, guadagnando in base ai clic ricevuti dal traffico che ancora viene veicolato dai vecchi link.

Se non bastasse, il rischio di perdere contenuti di valore sta aumentando col passare degli anni, mano a mano che quotidiani o riviste (e in alcuni casi anche libri) si spostano dal mondo fisico in quello digitale.

La differenza, dal punto di vista della conservazione, è colossale: un tempo, anche se chiudeva una rivista di storia o di cinema o di filosofia tutto il sapere lì racchiuso sarebbe comunque stato custodito da biblioteche e da tutte le persone che ne conservavano una copia in casa. Oggi, se chiude i battenti un sito web il rischio è di perdere tutto. Anche quando ci si abbona a una rivista online, non si sta più materialmente acquistando nulla: si ha solo la possibilità di accedere integralmente al sito.

Chiusa la rivista, o anche solo interrotto l’abbonamento, questo accesso viene bloccato. Per fare una metafora con il mondo delle riviste fisiche, non solo non giungeranno più nuovi numeri, ma verranno buttati via anche quelli che già possedevamo.

L’equivoco

Il mondo digitale che, agli albori, era ritenuto il modo migliore per conservare il sapere umano — rendendolo disponibile a chiunque, in qualsiasi momento e in ogni parte del globo — si sta improvvisamente rivelando in tutta la sua fragilità. Ed è forse ancora più preoccupante constatare che questa fragilità rischia di espandersi anche al mondo dell’arte, mano a mano che questa diventa più digitale e a volte conservata solo su internet.

Prendiamo il caso degli NFT, le certificazioni elettroniche salvate su blockchain che attestano la proprietà di un’opera d’arte digitale e che sono il fenomeno, anche economico, del 2021.

La certificazione è salvata su blockchain — ed esiste quindi finché almeno un computer è collegato al registro distribuito —, ma l’opera a cui rimanda è invece quasi sempre raggiungibile tramite un indirizzo web.

Di conseguenza, se per esempio uno dei siti specializzati in NFT chiudesse all’improvviso, sparirebbero anche le opere lì conservate. E così, l’NFT di video-art che hai pagato decine di migliaia di euro non varrebbe improvvisamente più nulla.

Gli archivi

Come se ne esce? I tentativi di porre rimedio a un problema sempre più evidente, fortunatamente, abbondano; anche se nessuno di questi è perfetto.

Il più noto è ovviamente l’Internet Archive, profeticamente fondato nel 1996 e che, da allora, anche tramite la sua Wayback Machine, si occupa di salvare, catalogare e rendere disponibili le pagine web anche dopo che sono scomparse (o mostrando come apparivano in passato). Basta inserire il link non più funzionante e incrociare le dita, sperando che l’Internet Archive se ne sia preso cura. Per inciso, anche su questo blog i link che nel tempo si rompono (ossia, scompaiono le pagine web cui i link rimandano) vengono recuperati tramite la “fotocopia” presente su Internet Archive.

Il suo fondatore, Brewster Kahle, riesce nell’impresa grazie a uno strumento che vaga per il web salvandone i contenuti e che, fino a oggi, ha archiviato oltre 600 miliardi di pagine. È un notevole esempio di biblioteca di internet, finanziata tramite donazioni e bandi.

Un altro caso è quello di Perma: progetto gestito da oltre 150 biblioteche che si occupa di salvare su richiesta degli autori dei contenuti di provato valore, per esempio articoli accademici o reportage giornalistici, garantendo di prendersi cura della loro conservazione in maniera, per l’appunto, permanente.

Copiare tutto

Il progetto in prospettiva più ambizioso è però probabilmente un altro e va sotto la sigla IPFS (interplanetary file system): un protocollo decentralizzato che permette di salvare una copia delle pagine presenti sul web — o di creane di nuove — distribuendo il loro contenuto ai computer collegati.

Quando si effettua una ricerca tramite IPFS, la richiesta non viene inviata a un server, ma a tutti i computer del network e che conservano almeno una parte di quella pagina.

Se stiamo cercando la pagina Wikipedia di Pompei, saranno quindi interpellati i computer collegati al sistema decentralizzato: se qualcuno la possiede, la pagina verrà visualizzata.

Questo non solo permette di avere a disposizione tutti i contenuti anche nel caso in cui Wikipedia subisca gravi problemi tecnici (come quelli che hanno recentemente mandato al tappeto Facebook), ma anche di rendere molto più complesso censurarli o eliminarli.

A differenza dell’Internet Archive o di Perma, quindi, l’IPFS non deve pagare per conservare i propri contenuti su classici server, ma sfrutta a questo scopo il network di computer connessi.

In alcuni progetti simili, come Arweave, la missione di custodire il world wide web è basata su blockchain e incentivata economicamente sfruttando le criptovalute. Usando le potenzialità di queste reti decentralizzate, nessuna inchiesta meritevole di Pulitzer — come quella citata prima — sarebbe potuta sparire: nemmeno nel caso estremo in cui realtà come l’Internet Archive o Perma chiudessero.

È sufficiente che un certo numero di computer sia connesso per conservare tutti i contenuti web, in maniera simile a come un sistema semi-clandestino come Torrent — in cui gli utenti mettono in condivisione materiale salvato sul loro computer — è diventato uno degli strumenti più affidabili per conservare film classici o di nicchia.

È attraverso questo tipo di sistemi che possiamo rendere il web più affidabile. Ed evitare che la più diffusa testimonianza digitale della nostra epoca diventi “404: Pagina non trovata”.

In definitiva, Internet non è l’archivio ideale, eterno e a portata di mano che ci eravamo immaginati.

A differenza di quanto pensavamo un tempo la memoria digitale si è rivelata essere molto meno solida di quanto era logico aspettarsi, molto più fragile di quella affidata a un supporto fisico come un libro di carta, assai più dipendente da variabili sulle quali non abbiamo grande controllo come i formati e l’hardware utilizzato o, più in generale, l’architettura stessa di rete, basata su protocolli e luoghi che hanno, nel loro essere effimeri, una della caratteristiche principali.

E quindi, come accade nel mio romanzo “La Memoria e il Dubbio” (qui sotto un estratto), il dubbio che sorge è che probabilmente il miglior modo che l’umanità abbia finora inventato per tramandare la memoria sia proprio il caro vecchio libro di carta.

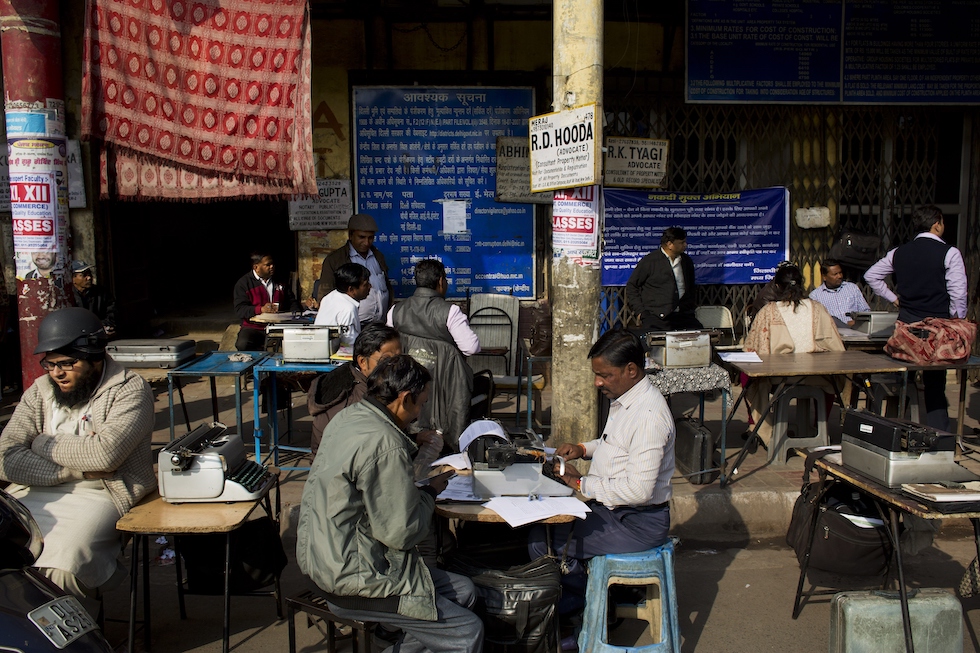

In India si usa ancora la macchina da scrivere

Il mondo, che in genere si dimostra più saggio e pragmatico di commentatori ed entusiasti del progresso, sembra pensarla allo stesso modo: il “documento cartaceo” è ancora di gran lunga più affidabile dei computer nel preservare e trasmettere il Sapere.

Nel 1936 il giudice indiano Pannalal Bose presentò le sue conclusioni su un caso criminale che in quel momento era il più noto e discusso del Paese, e riguardava il ritorno di un ricco nobile che tutti credevano morto, scomparso dieci anni prima a seguito di un tentato omicidio. Il giudice produsse un imponente rapporto di 531 pagine che aveva redatto personalmente con la sua macchina da scrivere portatile dell’azienda americana Remington Rand: è ancora abbastanza celebre in India come una notevole impresa di scrittura. Quasi un secolo dopo, benché computer, laptop e stampanti siano entrati nella vita quotidiana di miliardi di persone in tutto il mondo, in India le macchine da scrivere sono ancora molto utilizzate, sia per motivi pratici, sia per esigenze di altro tipo, e uno degli ambiti di maggior utilizzo è ancora quello giuridico.

In un lungo articolo su BBC Future si racconta che tradizionalmente fuori dai tribunali delle principali città dell’India, in particolare Delhi e Calcutta, lavoravano migliaia di incaricati il cui compito era trascrivere i documenti legali. Grazie al loro lavoro, le persone coinvolte nelle cause potevano avere subito a disposizione i documenti, che peraltro spesso dovevano anche essere tradotti nelle varie lingue che si parlano nel Paese.

Sebbene l’avvento degli strumenti digitali abbia portato a un comprensibile declino degli addetti che lavorano a macchina da scrivere fuori dai tribunali (e l’India sia uno dei Paesi più ricchi di programmatori e ingegneri del software), è un mestiere che continua a sopravvivere. Secondo stime citate sempre da BBC, nel 2014 fuori dai principali tribunali indiani lavoravano a macchina da scrivere ancora circa duemila persone.

Ci sono alcuni motivi per cui le macchine da scrivere portatili in India hanno continuato a essere così diffuse anche dopo che erano diventati molto più comuni i computer o comunque le macchine da scrivere elettroniche. Intanto, usarle offriva il vantaggio di poter continuare a lavorare anche in caso di interruzioni dell’energia elettrica, che in India sono un fenomeno frequente, e inoltre dava uno strumento anche a chi abitava nelle aree rurali più remote. In più, come ha spiegato a BBC Murugavel Prakash, che insegna come si scrive a macchina a 300 studenti in una scuola di Madurantakam —nel sud del Paese —, l’inchiostro delle macchine da scrivere «non scompare mai, al contrario di quello dei documenti stampati a computer».

E che dire del fax?

Laddove internet è una veloce rete digitale di computer, ancor oggi resiste uno strumento che è una… rete telefonica (però soltanto binaria), analogica e lentissima, di documenti di carta.

Il fax è un dispositivo che consente di trasmettere immagini attraverso una linea telefonica, ed è stato uno standard delle telecomunicazioni per molti anni. Dagli anni Ottanta è iniziato il suo declino e ormai da un bel po’, con la possibilità di inviare note e documenti attraverso mail e app di messaggistica, è considerato un reperto del passato. Nonostante questo, è ancora molto utilizzato in tutto il mondo: in Giappone si sta cercando di eliminarlo dagli uffici pubblici, non senza fatica; in Germania ogni azienda ne ha uno e anche in Italia se ne trovano ancora moltissimi, soprattutto negli uffici comunali. Lo scorso agosto si tornò a parlare di fax perché il calciatore del Barcellona Lionel Messi tentò invano di rescindere il proprio contratto inviandone uno alla sede del club.

Anche in Canada il fax è ancora molto utilizzato, soprattutto dalle aziende sanitarie, perché è ritenuto più sicuro rispetto alla posta elettronica: i medici lo usano per inviare le ricette di esami e da un anno anche quelle dei tamponi, che poi vengono stampate, timbrate e impilate prima di inviare le risposte di conferma. Una procedura piuttosto lenta e complicata, che negli ultimi mesi ha causato non pochi problemi. CBC, la televisione pubblica canadese, ha raccontato che lo scorso novembre un bambino rimase in isolamento per sei giorni prima di scoprire che la richiesta di tampone inviata dalla sua famiglia era andata persa. Lo stesso accadde a molte altre persone. Secondo le informazioni ottenute dalla CBC, i funzionari del dipartimento della salute del New Brunswick dovettero far fronte a un collo di bottiglia di circa 1.500 fax.

Il 20 maggio 2021 il governo tedesco ha approvato una nuova legge che prevede la digitalizzazione di centinaia di servizi della pubblica amministrazione, a cui gli utenti potranno accedere online autenticandosi coi dati della carta d’identità elettronica e un ulteriore codice identificativo. Sistemi di identificazione digitale simili sono utilizzati già da tempo in altri Paesi, Italia compresa, ma nonostante la sua reputazione di Stato molto efficiente, in Germania i processi di digitalizzazione erano rimasti piuttosto indietro: secondo alcuni esperti, questo è dipeso in parte dalla mancanza di tecnologie integrate tra di loro, ma soprattutto dalla mentalità dei tedeschi, che tendono a non fidarsi degli strumenti che possono permettere un controllo maggiore sulle loro vite (questo per inciso è anche il motivo per cui è praticamente impossibile usare Google Street View in Germania).

Nelle idee del governo tedesco, il nuovo sistema di identificazione non permetterà soltanto di rendere più efficienti e più facilmente fruibili i servizi dell’amministrazione pubblica, ma auspicabilmente contribuirà anche a eliminare burocrazia, contanti e strumenti obsoleti come il fax, che in Germania sono ampiamente diffusi. Al contempo, dovrebbe aiutare a superare la diffidenza dei tedeschi nei confronti degli strumenti digitali, che secondo gli esperti destano ancora qualche preoccupazione. I tedeschi sono particolarmente sensibili al tema della tutela della privacy per via del doloroso passato di controllo sulle libertà individuali da parte del regime nazista prima, e della Repubblica Democratica Tedesca (DDR) poi. Per questa ragione ancora oggi le leggi tedesche stabiliscono criteri molto restrittivi per il trattamento dei dati personali.

Scopri di più da L’internettuale

Abbonati per ricevere gli ultimi articoli via e-mail.

Be First to Comment